Claude Code: 5 провайдеров с Anthropic API в 2026

Пять китайских AI-провайдеров с нативной поддержкой Anthropic Messages API: Z.ai, DeepSeek, Kimi, MiniMax и Alibaba Qwen. Настройка, цены, ограничения.

TL;DR: Claude Code работает не только с моделями Anthropic. Пять китайских AI-провайдеров реализовали нативную совместимость с Anthropic Messages API: Z.ai (GLM-модели от $10/мес), DeepSeek ($0.28/M токенов), Kimi ($0.60/M), MiniMax ($0.30/M) и Alibaba Qwen (от $0.05/M). Подключаешь через ANTHROPIC_BASE_URL — и работаешь в Claude Code как обычно, только дешевле.Если ты пользуешься Claude Code, то знаешь: подписка Max стоит $100/мес, а API-токены улетают быстрее, чем хотелось бы. Но Anthropic предусмотрели возможность подключения сторонних провайдеров через переменную ANTHROPIC_BASE_URL — и несколько компаний этим воспользовались.

Меня интересовали провайдеры с нативной поддержкой Anthropic Messages API. Не прокси, не маркетплейсы, а те, кто реализовал совместимый эндпоинт у себя. Нашёл пять таких, все китайские. Совпадение? Не думаю.

Как это работает

Механика простая. Claude Code по умолчанию отправляет запросы на api.anthropic.com. Но если задать переменную ANTHROPIC_BASE_URL, запросы пойдут на указанный адрес. Провайдер на другом конце должен понимать формат Anthropic Messages API — и всё.

Настроить можно через ~/.claude/settings.json:

{

"env": {

"ANTHROPIC_BASE_URL": "https://your-provider.com/anthropic",

"ANTHROPIC_AUTH_TOKEN": "your-api-key"

}

}

Или через переменные окружения в ~/.zshrc:

export ANTHROPIC_BASE_URL="https://your-provider.com/anthropic"

export ANTHROPIC_AUTH_TOKEN="your-api-key"

Удобный вариант — shell-алиасы для быстрого переключения между провайдерами:

glm() {

ANTHROPIC_BASE_URL=https://api.z.ai/api/anthropic \

ANTHROPIC_AUTH_TOKEN="$ZAI_API_KEY" \

claude "$@"

}

dsk() {

ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic \

ANTHROPIC_AUTH_TOKEN="$DEEPSEEK_API_KEY" \

claude "$@"

}

Ещё можно переопределить, какая модель стоит за каждым алиасом Claude Code:

export ANTHROPIC_MODEL="glm-4.7"

export ANTHROPIC_SMALL_FAST_MODEL="glm-4.5-air"

Подробнее про все переменные окружения — в справочнике по переменным Claude Code.

1. Z.ai — GLM-модели от $10/мес

Z.ai — международный бренд Zhipu AI, разработчика семейства GLM. Они тренируют свои модели с нуля, это не перепродажа. Флагман GLM-5 весит 744 миллиарда параметров (MoE) и набирает 77.8 на SWE-bench Verified.

У Z.ai есть отдельный Coding Plan — подписка специально под AI-кодинг с Anthropic-совместимым эндпоинтом:

| План | Цена/мес | Модели | Промптов за 5 ч |

|---|---|---|---|

| Lite | $10 | GLM-4.5, 4.6, 4.7 | ~80 |

| Pro | $30 | + GLM-5 | ~400 |

| Max | $80 | + приоритет | ~1 600 |

Если подписка не нравится — можно платить за токены. GLM-4.7 стоит $0.60/$2.20 за миллион (вход/выход), GLM-5 — $1.00/$3.20. Для сравнения — Claude Sonnet 4 это $3/$15. Разница в 5-7 раз. А GLM-4.7-Flash вообще бесплатный.

Настройка:

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.z.ai/api/anthropic",

"ANTHROPIC_AUTH_TOKEN": "ваш-ключ-z-ai",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "glm-4.7",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "glm-5",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "glm-4.5-air",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": "1"

}

}

Есть нюансы, которые стоит знать. GLM-5 тратит квоту в 3 раза быстрее обычных моделей. На плане Lite GLM-5 вообще недоступна — только с Pro. В пиковые часы (14:00-18:00 UTC+8) бывают задержки, и судя по отзывам на Reddit, проблема не редкая. Серверы в Сингапуре — задержка из России заметная, но терпимая.

11 февраля 2026 Z.ai подняли цены на ~30% из-за роста спроса. Старые подписчики сохраняют прежние условия до конца текущего цикла оплаты.

Попробовать: z.ai

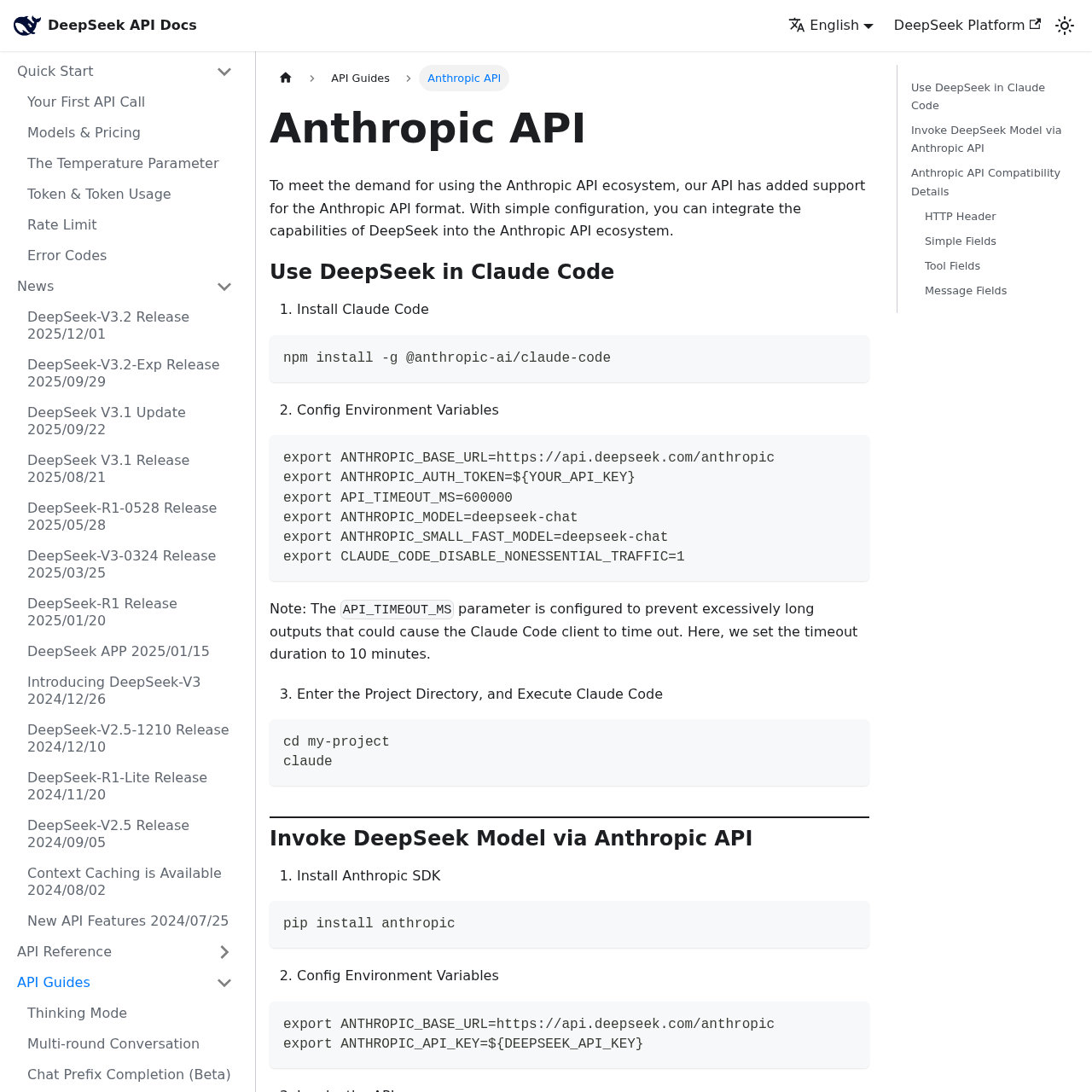

2. DeepSeek — reasoning по цене кофе

DeepSeek сделали свой Anthropic-совместимый эндпоинт, и настраивается он за минуту.

Настройка:

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.deepseek.com/anthropic",

"ANTHROPIC_AUTH_TOKEN": "ваш-deepseek-ключ",

"ANTHROPIC_MODEL": "deepseek-chat",

"ANTHROPIC_SMALL_FAST_MODEL": "deepseek-chat",

"API_TIMEOUT_MS": "600000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": "1"

}

}

Доступны две модели на базе DeepSeek-V3.2: deepseek-chat (общего назначения) и deepseek-reasoner (с цепочкой рассуждений, аналог extended thinking). Reasoning-модель хороша для сложных задач, когда надо разобраться в чужом коде или продебажить что-то неочевидное.

Цены — одни из самых низких на рынке: $0.28 за миллион входных токенов и $0.42 за выход. При попадании в кеш — $0.028. Это в 50-100 раз дешевле Claude Opus.

Но есть важные ограничения. Картинки не поддерживаются — если Claude Code попытается отправить скриншот, API вернёт ошибку 400. Prompt caching-директивы (cache_control) тихо игнорируются — каждый запрос платит полную стоимость входных токенов. И budget_tokens для thinking mode тоже не работает — модель сама решает, сколько рассуждать.

Ещё момент: если передать имя модели Claude (например, claude-sonnet-4-20250514), DeepSeek тихо подставит deepseek-chat без ошибки. Можно не заметить, что работаешь не с той моделью.

Со стабильностью бывает по-разному. Иногда запросы висят по 30-40 секунд, иногда всё летает. Поэтому API_TIMEOUT_MS=600000 (10 минут) — рекомендация от самих DeepSeek. Для основной работы я бы не стал полагаться только на них, но как бюджетный вариант — вполне рабочий.

Попробовать: deepseek.com

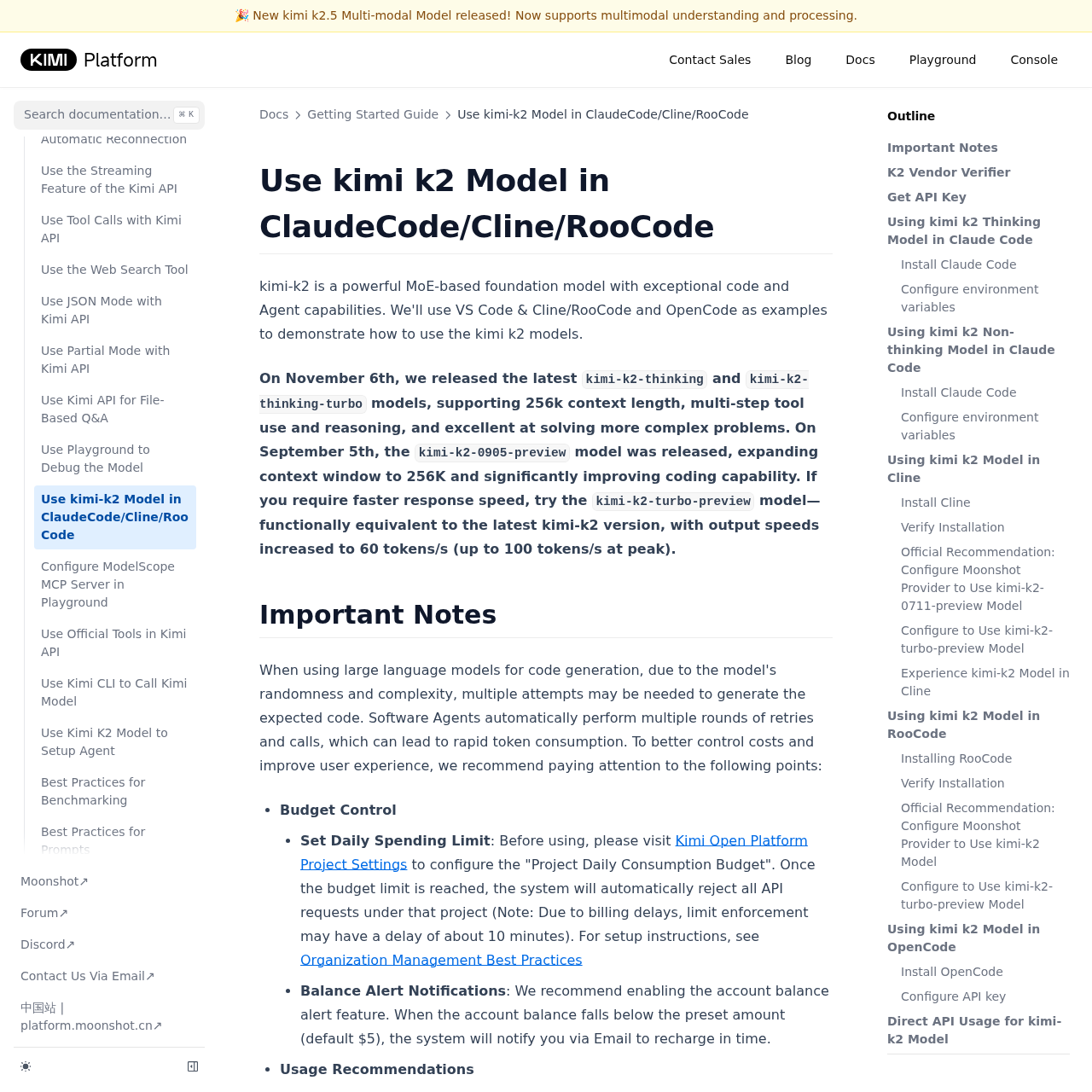

3. Kimi (Moonshot AI) — самый богатый выбор моделей

Moonshot AI, создатели ассистента Kimi, тоже реализовали Anthropic-совместимый эндпоинт. И у них, пожалуй, самая интересная линейка моделей из всех пяти провайдеров.

| Модель | Контекст | Thinking | Vision | Input $/M | Output $/M |

|---|---|---|---|---|---|

| kimi-k2.5 | 256K | Да | Да | $0.60 | $3.00 |

| kimi-k2-0905-preview | 256K | Нет | Нет | $0.60 | $2.50 |

| kimi-k2-thinking-turbo | 256K | Да | Нет | $1.15 | $8.00 |

| kimi-k2-turbo-preview | 256K | Нет | Нет | $1.15 | $8.00 |

kimi-k2.5 умеет и thinking, и vision, и agent-режим. Архитектура MoE: 1 триллион параметров, 32 миллиарда активных. При регистрации дают $5 бесплатного кредита, хватит потыкать.

Настройка:

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.moonshot.ai/anthropic",

"ANTHROPIC_AUTH_TOKEN": "sk-ваш-ключ-moonshot",

"ANTHROPIC_MODEL": "kimi-k2.5",

"ANTHROPIC_SMALL_FAST_MODEL": "kimi-k2-0905-preview",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": "1",

"API_TIMEOUT_MS": "600000"

}

}

kimi-k2-0905-preview при $0.60/$2.50 неплохо справляется с агентным кодингом. По данным Moonshot, модель стабильно работает на 200-300 последовательных tool calls. Для ежедневных задач цена приятная.

Есть особенность: Anthropic-эндпоинт пересчитывает температуру по формуле real_temperature = request_temperature × 0.6. Если Claude Code задаёт температуру 1.0, модель на самом деле получит 0.6. На практике разница малозаметная, но знать стоит.

Скорость генерации у обычных моделей (~34 tok/s) заметно ниже Claude Sonnet (~91 tok/s). Turbo-версии быстрее (60-100 tok/s), но и дороже в 3 раза.

Попробовать: platform.moonshot.ai

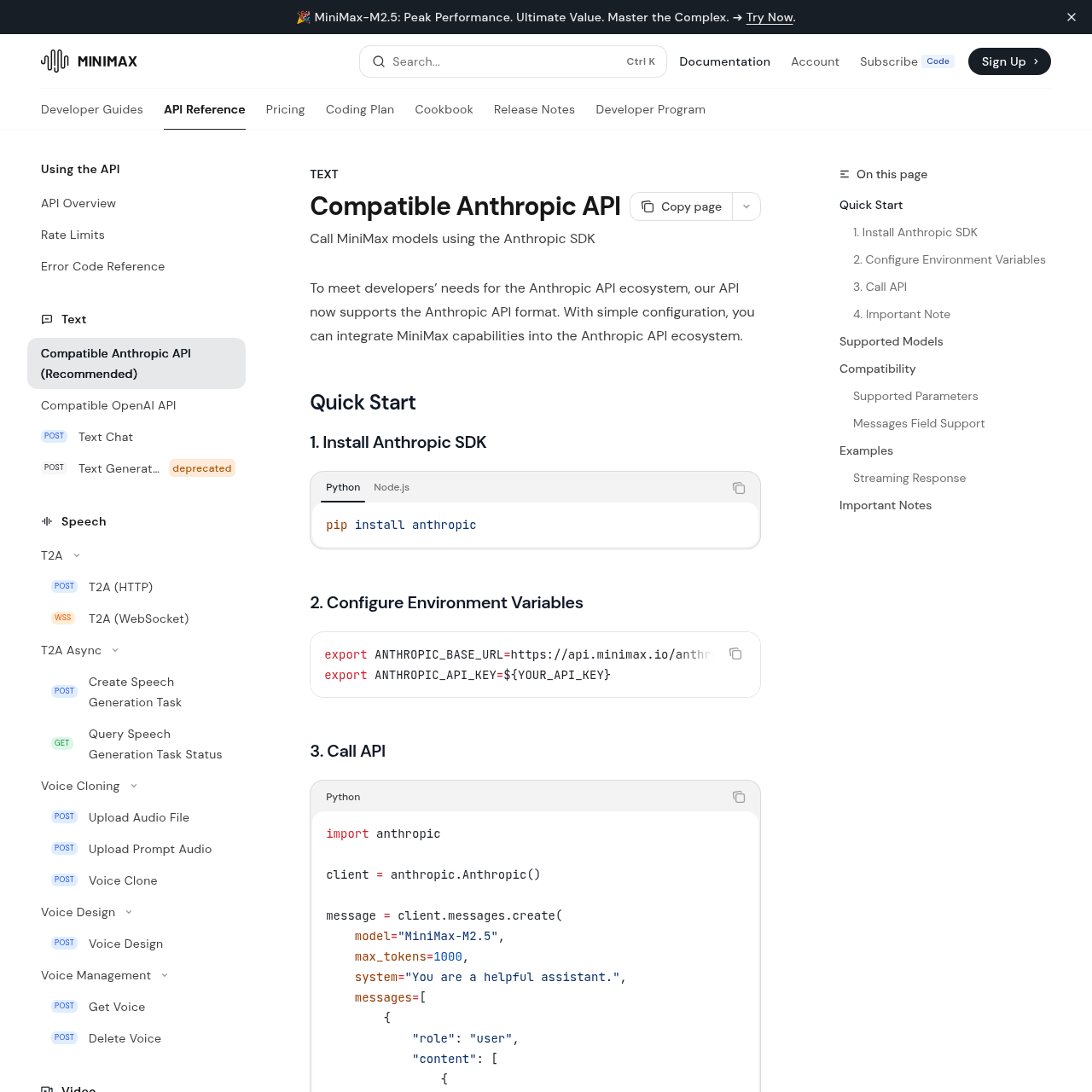

4. MiniMax — дешевле всех по токенам

MiniMax тихо сделали, пожалуй, самый дешёвый Anthropic-совместимый API. Флагман M2.5 — reasoning-модель на 230 миллиардов параметров (10 миллиардов активных, MoE). На SWE-bench Verified набирает 80.2%, что даже выше GLM-5.

Вот цены:

| Модель | Input $/M | Output $/M | Cache Read $/M | Скорость |

|---|---|---|---|---|

| MiniMax-M2.5 | $0.30 | $1.20 | $0.03 | ~60 tps |

| MiniMax-M2.5-highspeed | $0.60 | $2.40 | $0.03 | ~100 tps |

| MiniMax-M2.1 | $0.30 | $1.20 | $0.03 | ~60 tps |

| MiniMax-M2 | $0.30 | $1.20 | $0.03 | ~100 tps |

$0.30 за миллион входных токенов — это в 50 раз дешевле Claude Opus и в 10 раз дешевле Sonnet. А prompt cache read по $0.03 — вообще копейки, учитывая, что Claude Code отправляет большие системные промпты при каждом запросе.

Настройка:

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.minimax.io/anthropic",

"ANTHROPIC_AUTH_TOKEN": "ваш-ключ-minimax",

"ANTHROPIC_MODEL": "MiniMax-M2.5",

"ANTHROPIC_SMALL_FAST_MODEL": "MiniMax-M2.5",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": "1",

"API_TIMEOUT_MS": "3000000"

}

}

По совместимости с Anthropic API всё неплохо: tools, thinking, streaming работают. Картинки не поддерживаются (как и у DeepSeek). stop_sequences тихо игнорируется, а Claude Code их использует для управления генерацией, так что иногда модель выдаёт лишний текст на выходе.

И ещё: M2.5 любит поговорить. На бенчмарках она генерирует в 4 раза больше токенов, чем средняя модель. По деньгам это некритично (токены-то дешёвые), но ответы заметно длиннее, чем у Claude.

Попробовать: platform.minimax.io

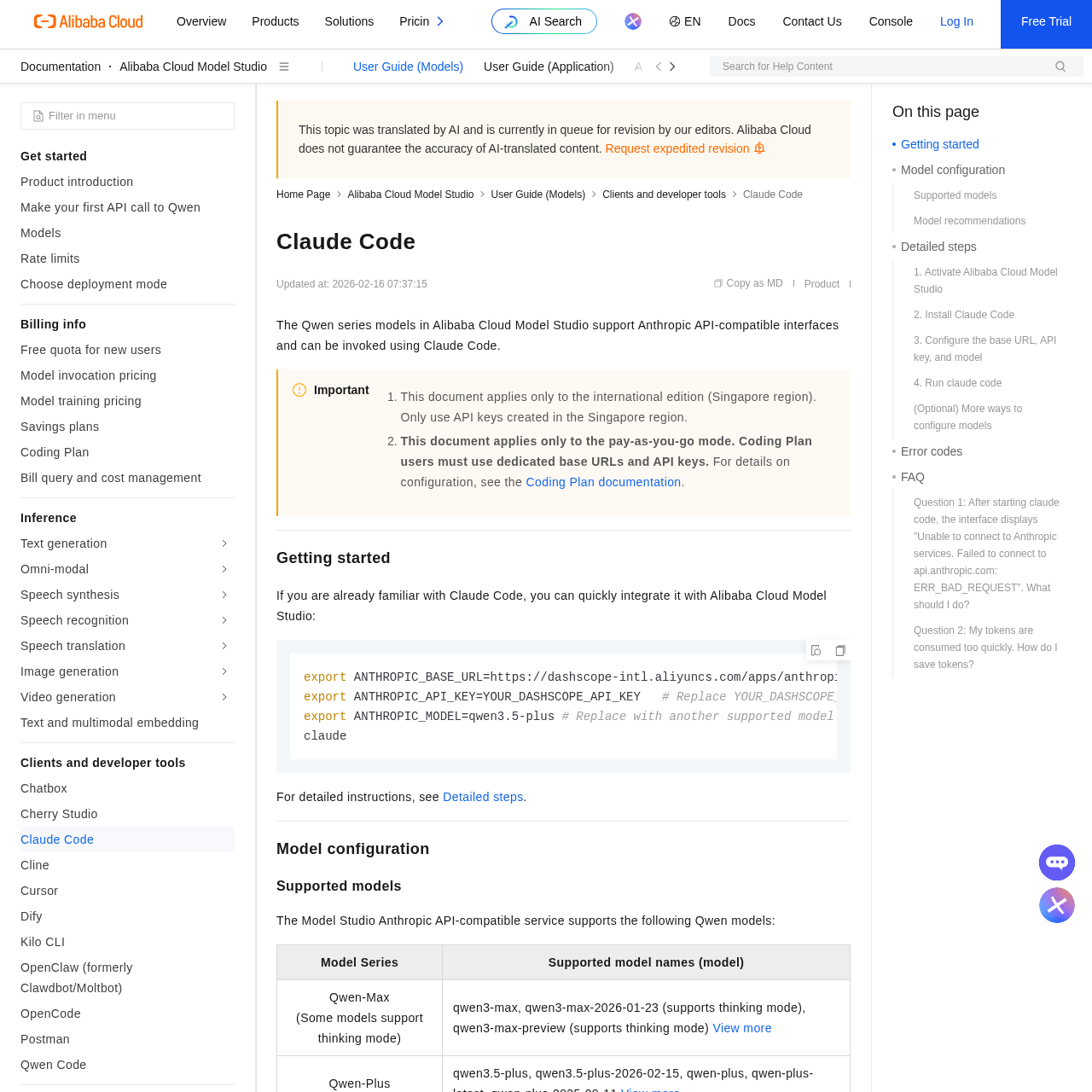

5. Alibaba Qwen — от $0.05 за миллион токенов

Alibaba Cloud Model Studio (DashScope) — самый крупный игрок в этом списке. Линейка моделей тут шире всех: от бюджетного qwen-flash за $0.05/M до qwen3-max за $1.20/M. Плюс отдельная кодинговая модель qwen3-coder-plus.

| Модель | Контекст | Thinking | Input $/M | Output $/M |

|---|---|---|---|---|

| qwen3-coder-plus | 1M | Нет | $1.00 | $5.00 |

| qwen3.5-plus | 1M | Да | $0.40 | $2.40 |

| qwen3-max | 252K | Да | $1.20 | $6.00 |

| qwen-flash | 1M | Нет | $0.05 | $0.40 |

Контекстное окно до 1 миллиона токенов, больше чем у остальных четырёх провайдеров. Но подвох в том, что цена растёт вместе с контекстом. qwen3-coder-plus при 0-32K стоит $1.00/$5.00, а при 256K-1M уже $6.00/$60.00. Claude Code склонен раздувать контекст, потому что отправляет полную историю разговора. Так что реальный чек может оказаться выше, чем ты рассчитывал.

Есть и свой Coding Plan — подписка для AI-кодинга:

| План | Цена/мес | Лимит за 5 ч | Лимит за месяц |

|---|---|---|---|

| Lite | $10 | 1 200 запросов | 18 000 запросов |

| Pro | $50 | 6 000 запросов | 90 000 запросов |

Лимиты заметно щедрее, чем у Z.ai: 1 200 запросов за 5 часов на Lite (у Z.ai — 80 промптов). Но учитывай, что один пользовательский запрос в Claude Code может генерировать 5-30 вызовов API.

Настройка pay-as-you-go:

{

"env": {

"ANTHROPIC_BASE_URL": "https://dashscope-intl.aliyuncs.com/apps/anthropic",

"ANTHROPIC_AUTH_TOKEN": "ваш-ключ-dashscope",

"ANTHROPIC_MODEL": "qwen3-coder-plus",

"ANTHROPIC_SMALL_FAST_MODEL": "qwen-flash"

}

}

Для Coding Plan — другой эндпоинт и ключ:

{

"env": {

"ANTHROPIC_BASE_URL": "https://coding-intl.dashscope.aliyuncs.com/apps/anthropic",

"ANTHROPIC_AUTH_TOKEN": "sk-sp-ваш-ключ-coding-plan"

}

}

Новым пользователям дают 1 миллион токенов бесплатно на каждую модель — хватит для серьёзного теста. А до 31 марта 2026 есть скидка 50% на первый месяц Coding Plan.

Из ограничений: картинки через международный Anthropic-эндпоинт не поддерживаются (на китайском работают через VL-модели). Thinking mode есть не у всех моделей — qwen3-coder-plus его не поддерживает.

Попробовать: alibabacloud.com/product/model-studio

Сравнительная таблица

| Провайдер | Модели | Input $/M | Output $/M | Подписка | Thinking |

|---|---|---|---|---|---|

| Z.ai | GLM-4.5 — GLM-5 | $0 — $1.20 | $0 — $5.00 | от $10/мес | Да (GLM-5) |

| DeepSeek | V3.2 (chat/reasoner) | $0.028 — $0.28 | $0.42 | Нет | Да (reasoner) |

| Kimi | K2, K2.5, K2-thinking | $0.10 — $1.15 | $2.50 — $8.00 | Нет | Да (K2.5, thinking) |

| MiniMax | M2, M2.1, M2.5 | $0.30 — $0.60 | $1.20 — $2.40 | Нет | Да (M2.5) |

| Alibaba | Qwen3-Coder, 3.5, Flash | $0.05 — $1.20 | $0.40 — $6.00 | от $10/мес | Да (3.5-plus, max) |

Для сравнения: Claude Sonnet 4 стоит $3/$15, Claude Opus 4.6 — $15/$75 за миллион токенов.

Что не работает у всех

Тут честно: ни один из пяти провайдеров не заменяет Claude полностью. Есть общие проблемы.

Vision — нигде толком не работает через Anthropic-эндпоинт. Kimi-k2.5 вроде поддерживает картинки, но именно через Anthropic API это ограничено. Если ты регулярно скидываешь скриншоты в Claude Code, будут ошибки.

Системный промпт Claude Code заточен под Claude. Другие модели могут не так точно следовать внутренним инструкциям. Я замечал, что на сложных multi-step задачах модели иногда теряют нить.

С prompt caching ситуация пёстрая. DeepSeek игнорирует cache_control полностью. MiniMax и Alibaba реализовали свой кеш. Z.ai и Kimi кешируют автоматически.

И обязательно добавляй CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1 при работе с любым сторонним провайдером. Без этого Claude Code шлёт фоновые запросы к Anthropic и впустую тратит квоту.

Какой провайдер выбрать

Думаю, выбор зависит от ситуации.

Нужен самый дешёвый вариант? DeepSeek за $0.28/M. Качество не Claude, но для быстрых задач хватает.

Хочешь подписку без подсчёта токенов? Z.ai Lite за $10/мес или Alibaba Lite за $10/мес. У Alibaba щедрее лимиты (1 200 запросов за 5 часов против 80 у Z.ai), зато у Z.ai модели GLM заточены под кодинг.

Важно соотношение цены и качества? Тогда MiniMax M2.5 за $0.30/$1.20. На SWE-bench набирает 80.2%, есть thinking mode, и при этом дешевле почти всех.

Нужен контекст до 1M токенов? Alibaba Qwen. Только следи за размером контекста: цена прыгает на длинных сессиях.

Хочешь thinking + vision + agents в одном? Kimi K2.5.

Лично я сижу на Claude Opus для основной работы, а для мелких задач переключаюсь на Z.ai через shell-алиас. Одна команда в терминале, и ты уже в том же Claude Code, но на другой модели.

FAQ

Можно ли использовать Claude Code вообще без подписки Anthropic?

Да. Если задать ANTHROPIC_BASE_URL на любого из пяти провайдеров, Claude Code будет работать без Anthropic API-ключа. Нужен только ключ от выбранного провайдера.

Будут ли работать все фичи Claude Code со сторонними моделями?

Не все. Extended thinking работает у тех моделей, которые его поддерживают (deepseek-reasoner, kimi-k2-thinking, MiniMax-M2.5, qwen3-max). Но vision, MCP passthrough и некоторые beta-фичи Anthropic — нет. Если возникают ошибки, добавь CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1.

Как быстро переключаться между провайдерами?

Shell-алиасы — лучший вариант. Добавь в ~/.zshrc функции для каждого провайдера и вызывай glm, dsk, kimi вместо claude. Подробнее про настройку — в гайде по settings.json.

Безопасно ли отправлять код через этих провайдеров?

Код уходит на серверы провайдера. Z.ai заявляет, что данные не хранятся (серверы в Сингапуре). DeepSeek — серверы в Китае. Alibaba — Сингапур для международного API. Для чувствительных проектов лучше использовать Anthropic напрямую или корпоративные решения вроде AWS Bedrock и Google Vertex.

Какие модели лучше всего работают с Claude Code?

По моему опыту, лучше работают модели, заточенные под код: GLM-5-Code, qwen3-coder-plus, kimi-k2-0905-preview. Универсальные тоже тянут, но с кодерскими специализациями меньше косяков.

Что ещё почитать

- Переменные окружения Claude Code — полный справочник — все переменные для настройки провайдеров

- Настройка Claude Code — полный гайд по settings.json — где и что прописывать

- GLM-5 от Zhipu — лучшая open-source модель 2026 — подробный обзор флагмана Z.ai

- Qwen 3.5 — мультимодальный AI от Alibaba — обзор моделей Alibaba

- Claude Opus 4.6 — обзор самой умной модели Anthropic — с чем сравнивать альтернативы

- GPT-5.3 Codex vs Claude Opus 4.6 — если выбираешь между ними