GLM-5 от Zhipu — лучшая open-source модель 2026

Zhipu AI выпустила GLM-5 — open-source модель на 744B параметров с MIT-лицензией. Разбираю бенчмарки и сравниваю с закрытыми моделями.

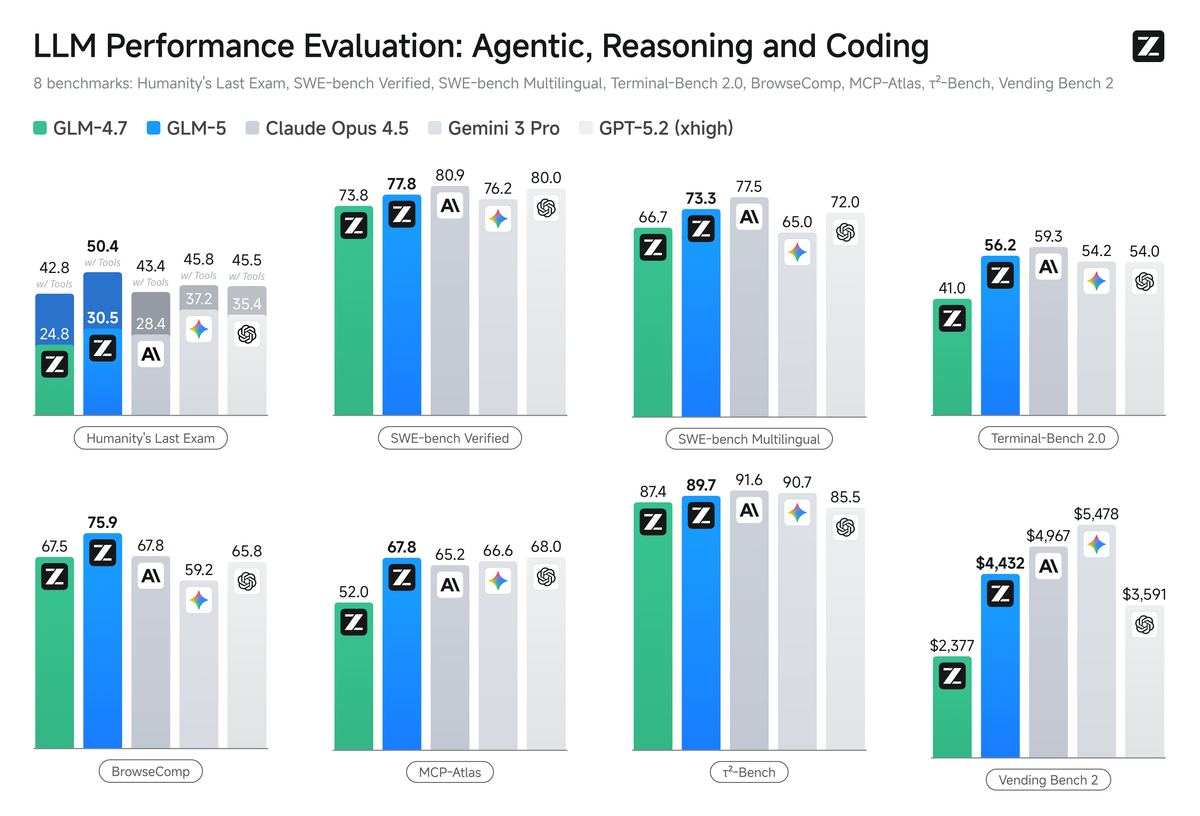

TL;DR: Zhipu AI выпустила GLM-5 — open-source модель на 744B параметров с MIT-лицензией. По бенчмаркам это лучшая открытая модель для кодинга и агентных задач, а на некоторых тестах она подбирается вплотную к Claude Opus 4.5.

Кто такие Zhipu и зачем им ещё одна модель

Zhipu AI — китайская компания, которая развивает линейку моделей GLM. Если ты следил за предыдущими релизами, то помнишь GLM-4.5 и GLM-4.7. Новая GLM-5 — не инкрементальное обновление, а серьёзный скачок. Компания позиционирует модель для сложных инженерных задач и долгосрочных агентных сценариев.

Модель доступна на HuggingFace и ModelScope под MIT-лицензией. Можно брать и использовать в коммерческих проектах без ограничений.

Что внутри

GLM-5 выросла до 744 миллиардов параметров, из которых 40 миллиардов активны (архитектура Mixture of Experts). Для сравнения: GLM-4.5 была 355B с 32B активными. Данные для обучения тоже увеличились — с 23 до 28.5 триллионов токенов.

Интересная деталь: GLM-5 использует DeepSeek Sparse Attention (DSA). Это технология от DeepSeek, которая снижает стоимость деплоя и при этом сохраняет работу с длинным контекстом. Получается, китайские AI-компании активно заимствуют друг у друга лучшие наработки.

Для обучения с подкреплением в Zhipu разработали собственную инфраструктуру slime — асинхронный RL-фреймворк. По их данным, это позволило ускорить пост-тренинг и делать более тонкие итерации при файн-тюнинге.

Как выглядят бенчмарки

Тут начинается самое интересное. Собрал ключевые цифры в таблицу:

| Бенчмарк | GLM-5 | DeepSeek-V3.2 | Kimi K2.5 | Claude Opus 4.5 | GPT-5.2 |

|---|---|---|---|---|---|

| SWE-bench Verified | 77.8 | 73.1 | 76.8 | 80.9 | 80.0 |

| SWE-bench Multilingual | 73.3 | 70.2 | 73.0 | 77.5 | 72.0 |

| Terminal-Bench 2.0 | 56.2 | 39.3 | 50.8 | 59.3 | 54.0 |

| BrowseComp | 62.0 | 51.4 | 60.6 | 37.0 | — |

| Vending Bench 2 | $4,432 | $1,034 | $1,198 | $4,967 | $3,591 |

| AIME 2026 I | 92.7 | 92.7 | 92.5 | 93.3 | — |

Несколько наблюдений.

На SWE-bench Verified — стандартном тесте для кодинга — GLM-5 набирает 77.8%. Лучший результат среди всех open-source моделей. Claude Opus 4.5 впереди с 80.9%, но разрыв меньше 3 процентных пунктов. GPT-5.2 на уровне 80%.

На BrowseComp, который оценивает навигацию по вебу, GLM-5 обгоняет Claude Opus 4.5 — 62.0 против 37.0. С context management разрыв сокращается (75.9 у GLM-5, 67.8 у Claude), но всё равно заметный.

Vending Bench 2 — необычный тест, где модель управляет вендинговым бизнесом на горизонте в один год. GLM-5 заработала $4,432, почти догнав Claude Opus 4.5 ($4,967). Для open-source модели это первое место. Тестирование проводилось независимо лабораторией Andon Labs.

В математике (AIME 2026) все топовые модели идут ноздря в ноздрю — разница в десятых долях процента.

Где GLM-5 проигрывает: GPQA-Diamond (86.0 против 91.9 у Gemini 3.0 Pro) и Tool-Decathlon (38.0 против 46.3 у GPT-5.2). До универсального лидерства пока далеко.

Генерация документов

GLM-5 умеет создавать .docx, .pdf и .xlsx файлы из текстовых описаний. Техзадания, учебные планы, финансовые отчёты — модель собирает в готовые документы. На Z.ai для этого есть Agent mode с встроенными навыками.

Я не тестировал эту фичу лично, поэтому не могу сказать, насколько хорошо это работает на практике. Но сама идея перехода от «чата» к «рабочему инструменту» выглядит правильной.

Как попробовать

Через Z.ai — бесплатный чат и агентный режим. Нужно вручную выбрать модель GLM-5 в настройках.

Через Claude Code — если подписан на GLM Coding Plan (Max-тариф). Достаточно прописать "GLM-5" в ~/.claude/settings.json. Учти, что GLM-5 съедает больше квоты, чем GLM-4.7.

Локально — веса на HuggingFace под MIT-лицензией. Поддерживаются vLLM и SGLang для инференса. Кроме NVIDIA, работает на чипах Huawei Ascend, Moore Threads и других китайских процессорах. Подробные инструкции на GitHub Zhipu.

Ещё есть OpenClaw — фреймворк, который превращает GLM-5 в ассистента для управления приложениями и устройствами. Входит в GLM Coding Plan.

Вывод

GLM-5 — на сегодня сильнейшая open-source модель для кодинга и агентных задач. MIT-лицензия, совместимость с популярными инструментами, конкурентные бенчмарки. Разрыв с закрытыми моделями типа Claude Opus 4.5 и GPT-5.2 сократился до нескольких процентных пунктов.

Стоит ли переключаться? Если работаешь с open-source — однозначно стоит попробовать. Если используешь Claude или GPT — скорее нет, закрытые модели пока впереди на большинстве задач. Но тенденция очевидна: open-source догоняет.

Что ещё почитать

- Claude Opus 4.6 — обзор самой умной модели Anthropic — сравниваем с GLM-5 в бенчмарках выше

- GPT-5.3 Codex vs Claude Opus 4.6 — ещё одно сравнение топовых моделей

- Kimi K2.5 — китайский open-source с роем агентов — другая сильная open-source модель из Китая

FAQ

Сколько параметров в GLM-5? 744 миллиарда общих параметров, из которых 40 миллиардов активны одновременно. Используется архитектура Mixture of Experts, обучение на 28.5 триллионах токенов.

Можно ли использовать GLM-5 в коммерческих проектах? Да. Модель распространяется под MIT-лицензией. Ограничений на коммерческое использование нет.

Как GLM-5 сравнивается с Claude Opus 4.5? На SWE-bench Verified GLM-5 набирает 77.8% против 80.9% у Claude Opus 4.5. На задачах веб-навигации GLM-5 иногда выигрывает. В целом Claude пока впереди, но разрыв сокращается.

Где скачать веса GLM-5? На HuggingFace и ModelScope. Для локального запуска поддерживаются vLLM и SGLang. Инструкции на GitHub-репозитории Zhipu.