Как экономить токены в Cursor и Claude Code

Как тратить в 3-5 раз меньше на AI-кодинг. Правильная модель для каждой фазы задачи, разделение контекстов и реальные цены на февраль 2026.

TL;DR: Разбиваешь задачу на фазы (контекст → план → код → тесты → дебаг), для каждой фазы берёшь модель нужного уровня. Контекст собираешь дешёвыми моделями, планируешь умными, генерируешь код снова дешёвыми. Не смешиваешь фазы в одном чате. Экономия — до 3-5 раз.

Если ты активно кодишь с AI, то наверняка замечал: лимиты подписки улетают за пару дней, а счёт за API в конце месяца неприятно удивляет. Причём чаще всего проблема не в инструменте, а в том, как мы его используем.

Подход работает для Cursor, Claude Code и вообще любого инструмента с мультимодельным доступом.

Что понадобится

- Подписка на AI-кодинг: Cursor Pro/Pro+ ($20-60/мес) или Claude Pro/Max ($20-200/мес). Можно и через API, но подписка для ежедневной работы обычно выгоднее

- Доступ к нескольким моделям (в Cursor и Claude Code это есть из коробки)

- Готовность перестать кидать всё в один бесконечный чат

Шаг 1. Пойми, за что ты платишь

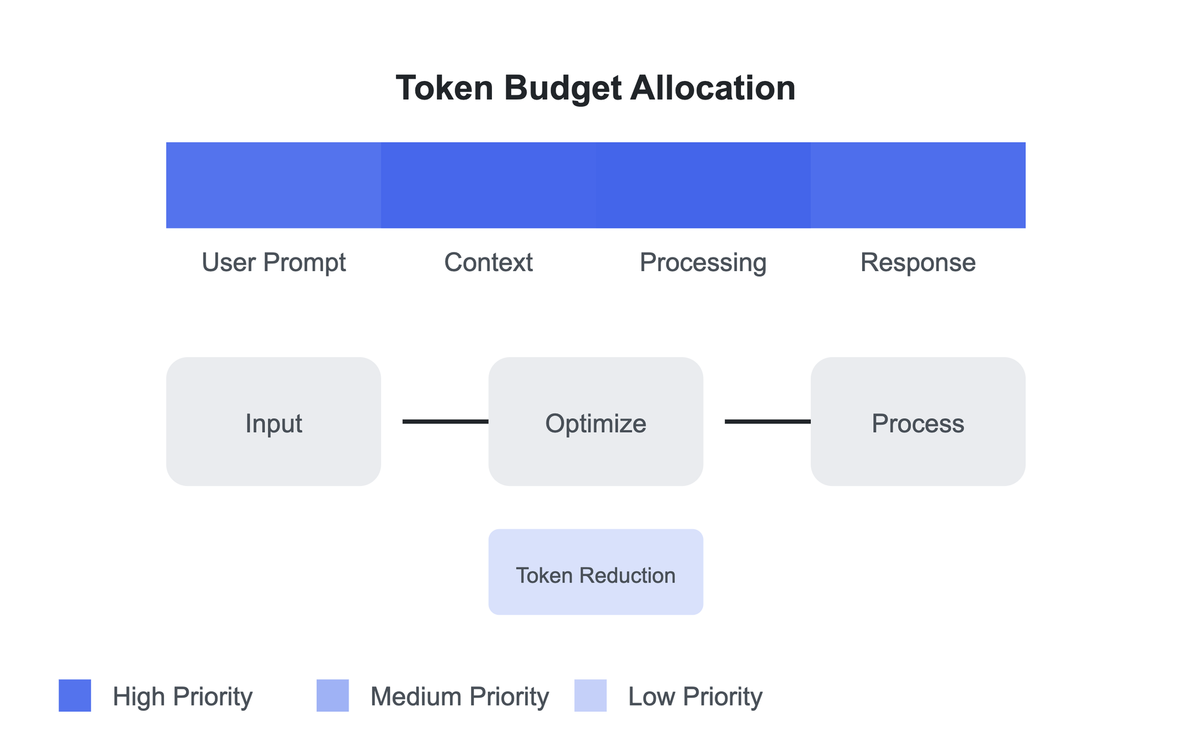

Прежде чем что-то оптимизировать, нужно разобраться, откуда берётся цена. Каждый запрос к модели складывается из четырёх частей:

Input — то, что ты отправляешь: промпт, код, файлы, контекст чата. С каждым новым сообщением этот кусок растёт, потому что модель «помнит» всю историю.

Output — то, что модель генерирует в ответ. Самый дорогой компонент. Часто в 5-8 раз дороже input.

Cache Write — запись контекста в кэш для повторного использования.

Cache Read — чтение из кэша. Самая дешёвая часть, бывает в 10 раз дешевле обычного input.

Вот актуальные цены на февраль 2026 года (за 1 миллион токенов):

| Модель | Input | Output | Cache Read |

|---|---|---|---|

| Claude Opus 4.6 | $5.00 | $25.00 | $0.50 |

| Claude Sonnet 4.5 | $3.00 | $15.00 | $0.30 |

| Claude Haiku 4.5 | $1.00 | $5.00 | $0.10 |

| GPT-5.2 | $1.75 | $14.00 | — |

| GPT-5-mini | $0.30 | $1.00 | — |

| Gemini 3.0 Pro | $2.00 | $12.00 | — |

| Gemini 2.5 Flash | $0.30 | $2.50 | $0.025 |

Посмотри на разброс. Output у Opus стоит в 25 раз дороже, чем у GPT-5-mini. Input у Gemini Flash — в 17 раз дешевле, чем у Opus. Гонять флагманскую модель на всех задачах подряд — это как ездить на Porsche в булочную.

Отдельно про режим Auto в Cursor. Он использует фиксированные ставки: Input $1.25/1M, Output $6.00/1M, Cache Read $0.25/1M. Это дешевле, чем вручную выбрать Opus. Но, Auto оптимизирует скорее нагрузку, чем цену. Cursor балансирует стабильность и скорость, а не экономит тебе деньги.

Шаг 2. Раздели задачу на фазы

Главная ошибка, которую делают почти все: работать над задачей в одном длинном чате с одной любимой моделью.

Вместо этого раздели работу на этапы:

- Подготовка контекста — собрать и переварить входные данные

- Бизнес-логика — обсудить требования, принять решения

- Архитектура — спроектировать структуру

- Планирование тестов — определить, что тестировать (не писать тесты, а именно спланировать)

- Генерация кода и тестов — собственно написание

- Ревью — проверка

- Дебаггинг — поиск и исправление багов

- Текучка — коммиты, документация, мелочи

Каждая фаза = отдельный чат. Результат каждой фазы — выжимка в markdown, которая становится входом для следующей.

Почему это работает? К 20-му сообщению в одном чате ты платишь за контекст в 100-200K токенов. Половина из них — старые обсуждения, которые уже неактуальны. Модель жуёт мусор. А ты за это платишь.

Шаг 3. Подбери модель для каждой фазы

Вот тут самая мякотка. Каждый этап требует разного баланса между качеством мышления и ценой.

Подготовка контекста (фаза 0)

Тебе нужно обработать файлы, логи, документацию, скриншоты и выдать краткую выжимку. Тут важен дешёвый input и большое контекстное окно. Глубокие рассуждения не нужны.

Типичная ошибка — скормить весь исходный контекст сразу Opus или другому флагману. Мол, он лучше разберётся. На практике наоборот: с ростом контекста умные модели начинают галлюцинировать. Простые справляются отлично, им и надо просто вытащить суть.

Бери: GPT-5-mini ($0.30/$1.00), Gemini 2.5 Flash ($0.30/$2.50) или Claude Haiku 4.5 ($1.00/$5.00).

На выходе: компактный markdown — что за проект, какие ограничения, что нужно сделать.

Бизнес-логика и архитектура (фазы 1-2)

На входе — выжимка из предыдущего шага (компактная, без мусора). На выходе — решения и план.

Тут нужна умная модель. Экономить на думании — себе дороже. Плохой план обойдётся в десятки переделок на следующих этапах. Я сам на этом обжигался: сэкономил на планировании, потом три дня разгребал.

Бери: Claude Opus 4.6 ($5/$25), GPT-5.3 ($1.75/$14) или Gemini 3.0 Pro ($2/$12). Можно даже перекрёстно проверить: спланировал на Opus, валидировал на GPT-5.3.

В Cursor для этого отлично подходит Planning Mode.

Планирование тестов (фаза 3)

Именно планирование, не написание. Определить тест-кейсы, граничные случаи, что именно проверять.

Бери: те же модели, что для бизнес-логики. На выходе: список тест-кейсов в markdown.

Генерация кода и тестов (фаза 4)

Основной объём расхода. Нужен дешёвый output и хорошая специализация на коде. План уже готов, осталось написать код по нему.

Бери: GPT-5-mini ($0.30/$1.00) для типовых задач, Claude Sonnet 4.5 ($3/$15) для среднего уровня, GPT-5.3 ($1.75/$14) для сложной логики.

Тут важнее не когда тесты пишутся, а когда они включаются в контекст. Результаты тестов валятся в контекст агенту, и вместо продолжения генерации он примется лепить фиксы. Это расходует токены впустую и забивает контекстное окно мусором.

С TDD-подходом же, когда тесты написаны заранее, модель лучше понимает задачу. При этом засоряя контекст ошибками. Тут стоит выбирать, что нравится именно тебе.

Ревью (фаза 5)

Для общего ревью хватит Sonnet 4.5. Для точечного разбора сложных мест — Opus.

Дебаггинг (фаза 6)

Тут два этапа. Сначала дешёвой моделью (Haiku, GPT-5-mini) собираешь информацию: логи, стектрейсы, локализуешь проблему. Потом с выжимкой идёшь к умной модели за решением.

Логика простая: зачем платить $25 за миллион output-токенов, чтобы Opus читал стектрейсы? Haiku справится за $5.

Текучка (фаза 7)

Коммиты, мелкие правки, форматирование, документация. Самая дешёвая модель, какая есть. Claude Code, кстати, уже так делает: использует Haiku для валидации bash-команд и чтения файлов.

Шаг 4. Один чат — одна фаза

Наверное, самый простой совет во всей статье. Закончил этап — скопировал результат — открыл новый чат.

В Claude Code для этого есть /compact, который сжимает контекст. Но, честно говоря, чистый новый чат с выжимкой из предыдущего работает лучше. Проверено.

В Cursor — просто открывай новый Composer для каждой фазы. Старые чаты можно оставить для референса, но не продолжать в них.

Шаг 5. Используй шаблоны и skills

Подготовленные инструкции сильно снижают расход. Вместо того чтобы объяснять модели контекст проекта при каждом обращении, ты загружаешь компактные правила один раз.

В Cursor это файл .cursorrules с описанием архитектуры и code style. Можно добавить rules с триггерами по команде.

В Claude Code — файл CLAUDE.md с инструкциями проекта плюс slash-команды для типовых операций. Skills существенно уменьшают количество токенов в последующих итерациях. По моему опыту, хороший CLAUDE.md с правилами экономит кучу контекста.

Общий принцип: разжёванная инструкция + дешёвая модель часто даёт результат не хуже, чем дорогая модель без инструкции. При этом стоит в разы меньше.

Шаг 6. Следи за расходом

Без мониторинга оптимизация бесполезна. Где смотреть:

В Cursor — Dashboard → Usage. Видно расход по моделям и запросам, там же можно поставить бюджетный лимит. В Claude Code — команда /context показывает расход контекстного окна текущей сессии прямо в терминале. Через API — консоль Anthropic или OpenAI с детальной разбивкой по токенам.

Совет: первую неделю просто понаблюдай, куда уходят токены. Скорее всего, обнаружишь, что 70-80% расхода приходится на одну-две модели в длинных чатах.

Результат

Если применил все шаги, примерная стоимость типовой задачи (небольшая фича, 200-500 строк кода):

| Фаза | Модель | Примерный расход |

|---|---|---|

| Контекст | GPT-5-mini | $0.02-0.05 |

| Планирование | Opus 4.6 | $0.20-0.50 |

| Генерация кода | Sonnet 4.5 | $0.30-1.00 |

| Ревью | Sonnet 4.5 | $0.10-0.20 |

| Дебаг (сбор инфо) | Haiku 4.5 | $0.01-0.05 |

| Дебаг (решение) | Opus 4.6 | $0.10-0.30 |

| Текучка | Haiku 4.5 | $0.01-0.02 |

| Итого | $0.75-2.10 |

Для сравнения: если всё делать через Opus в одном чате, та же задача обойдётся в $3-8. Разросшийся контекст и избыточный output делают своё дело. Не скажу, что эти цифры точные — зависит от задачи, размера проекта и того, насколько ты разговорчив с моделью. Но порядок такой.

Какой тариф выбрать

Раз уж мы про деньги, вот шпаргалка по тарифам на февраль 2026.

Cursor:

- Pro ($20/мес) — $20 кредитов на модели + безлимитный Tab и Auto. Хватает, если кодишь пару часов в день

- Pro+ ($60/мес) — 3x кредитов ($70). Для тех, кому Pro не хватает к середине месяца

- Ultra ($200/мес) — 20x кредитов ($400). Для хардкорных пользователей

Claude (включая Claude Code):

- Pro ($20/мес) — базовые лимиты, основная модель Sonnet. Для регулярной, но не интенсивной работы

- Max 5x ($100/мес) — 5x лимитов, приоритетный доступ. Для ежедневной профессиональной работы

- Max 20x ($200/мес) — 20x лимитов. Для тех, кто пишет код целый день

Для ежедневной работы подписка почти всегда выгоднее API. По подсчётам сообщества, подписка может быть до 36 раз дешевле чистого API при активном использовании.

FAQ

Подписка или API — что выгоднее для ежедневного кодинга?

Подписка. Claude Pro за $20 даёт значительно больше, чем можно купить за те же $20 через API. Если работаешь с кодом каждый день — однозначно подписка. API имеет смысл при нерегулярном использовании (пару раз в неделю) или при очень высоких объёмах, когда даже Max 20x не хватает.

Claude Code сам выбирает модели — зачем мне заморачиваться?

Claude Code действительно автоматически отправляет простые задачи на Haiku — чтение файлов, bash-команды. Но основную модель и длину контекста контролируешь ты. Разбиение на короткие сессии, планирование в отдельном чате, порядок фаз — это твоя ответственность, а не модели.

Работает ли этот подход для проектов с нуля?

Да. Начальный каркас (фреймворки, бойлерплейт) собирай дешёвой моделью — по документации это делается почти механически. Бизнес-логику и архитектуру — умной. Для типового кода бери дешёвые модели, для сложной логики — флагманы.

Какой размер кодовой базы ещё нормально работает с AI?

Проекты до 100-250 тысяч строк работают нормально. Для больших проектов изолируй контекст, выдели конкретный модуль или фичу.

Что насчёт TDD — писать тесты до кода экономнее?

Неоднозначный вопрос. С одной стороны, тесты до кода помогают модели лучше понять задачу — меньше итераций. С другой — если тесты попадают в контекст агента во время генерации, они засоряют окно промежуточными результатами. Компромисс: спланируй тесты заранее (фаза 3), но генерируй и запускай их отдельно (фаза 4).

Что ещё почитать

- GPT-5.3 Codex vs Claude Opus 4.6 — сравнение двух флагманов для кодинга, чтобы понять, когда какой выбирать

- CLAUDE.md — как писать инструкции для Claude Code — настройка правил проекта, чтобы модель не тратила токены на «понимание» контекста с нуля

- Claude Code Hooks — автоматизация — как автоматизировать рутинные фазы работы

- Fast Mode в Claude Code — когда скорость важнее экономии