Kimi K2.5 — китайский open-source с роем из 100 агентов

Moonshot выпустили Kimi K2.5 — мультимодальную модель с vision, кодингом и рой-архитектурой до 100 параллельных агентов

TL;DR: Moonshot выкатили Kimi K2.5 — open-source модель, которая умеет запускать рой из 100 агентов параллельно, делать до 1500 tool calls за задачу и работает в 4.5 раза быстрее одиночного агента. Плюс сильный vision и кодинг.

Китайцы из Moonshot не дают расслабиться. Только недавно они выпустили K2, а тут уже K2.5 — и это не просто минорный апдейт.

Что нового

K2.5 дообучили на 15 триллионах токенов текста и картинок. Это нативная мультимодальная модель, то есть vision не прикрутили сбоку, а встроили с самого начала.

Главная фишка - agent swarm. Модель сама создаёт до 100 подагентов и раздаёт им задачи параллельно. Никаких предзаданных ролей или хардкода - K2.5 сам решает, каких специалистов создать и как распределить работу.

В итоге получается до 1500 tool calls за одну задачу, а скорость выполнения растёт в 4.5 раза по сравнению с обычным подходом «один агент делает всё по очереди».

Метод PARL

Moonshot назвали свой метод PARL — Parallel-Agent Reinforcement Learning. Идея такая: есть главный агент-оркестратор, который декомпозирует задачу на части. Каждую часть выполняет отдельный подагент.

Проблема в том, что учить такую систему сложно: фидбэк приходит с задержкой, от разных агентов, и всё это меняется по ходу обучения. Плюс есть риск «коллапса в последовательность», когда оркестратор забивает на параллелизм и гоняет всё по очереди.

Чтобы побороть это, они ввели награду за параллелизм на ранних этапах обучения. Постепенно эта награда затухает, и модель переключается на качество результата.

Vision + Code

K2.5 хорошо работает с картинками и кодом одновременно. Можешь скинуть скриншот интерфейса — модель сгенерирует код. Или показать видео сайта — она его воспроизведёт.

Интересный пример из блога: K2.5 дали картинку лабиринта и попросили найти кратчайший путь. Модель сама написала код на Python с BFS-алгоритмом, обработала картинку, нашла путь из 113 тысяч шагов и визуализировала результат.

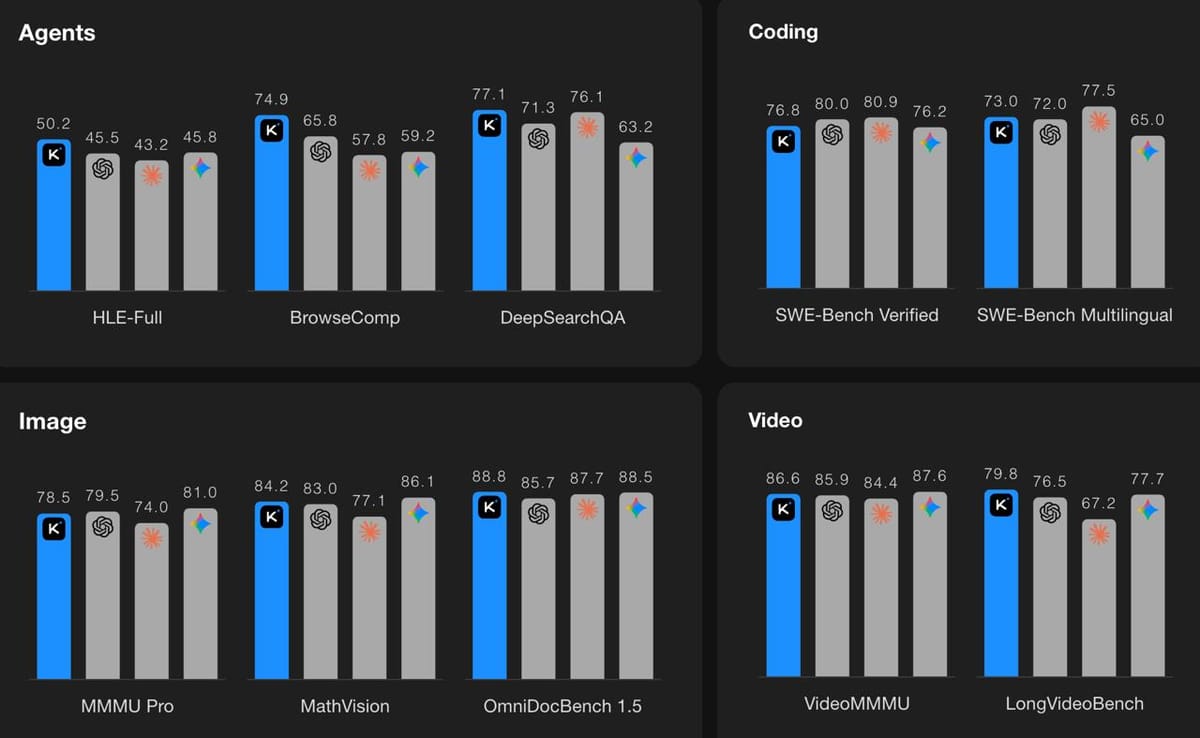

Бенчмарки

На SWE-Bench Verified модель показала 76.8%. Это рядом с GPT-5.2 (80%) и Claude Opus 4.5 (80.9%). На агентных бенчмарках интереснее: K2.5 в режиме swarm набрал 78.4% на BrowseComp, обойдя всех остальных.

Vision тоже неплохой — MMMU-Pro 78.5%, VideoMMMU 86.6%. Хотя, честно говоря, эти цифры мало что говорят без реального опыта использования.

Где попробовать

Модель доступна на kimi.com, в приложении Kimi, через API и в Kimi Code — это их терминальный клиент вроде Claude Code. Есть четыре режима: K2.5 Instant, K2.5 Thinking, K2.5 Agent и K2.5 Agent Swarm (пока в бета).

Agent Swarm пока дают бесплатно пользователям платных тарифов.

Не знаю, насколько хорошо это будет работать на реальных задачах — бенчмарки это одно, а практика другое. Но сама идея роя агентов выглядит правильной. Вместо того чтобы делать одну модель умнее, они масштабируют параллельно. Посмотрим, приживётся ли такой подход.

Что ещё почитать

- Oh My Claude Code: мультиагентная система для тех, кому лень настраивать Claude Code — если интересна тема мультиагентов

- В Claude Code нашли мультиагентную систему — TeammateTool — скрытые мультиагентные возможности в Claude