Taalas HC1: AI-модель стала чипом — 17 000 токенов/сек

Taalas поднял $169M и показал чип, который запекает AI-модель прямо в кремний. 17 000 токенов/сек против 200 у GPU — реальность или маркетинг?

TL;DR: Taalas запекает LLM прямо в ASIC-кремний и получает 17 000 токенов/сек — в 100 раз быстрее GPU. Цифра «1000x» с сайта — маркетинг, но реальные результаты тоже впечатляют. Главный вопрос не в скорости, а в том, смогут ли датацентры жить с кастомным чипом под каждую модель.

Два дня назад Forbes написал про стартап Taalas с заголовком «инсейн-перформанс» — и я потратил час, разбираясь что там вообще происходит. Оказалось, там действительно есть что обсудить.

Taalas существует два с половиной года. Команда из 24 человек, $169 млн поднятых инвестиций. Они делают не ещё один GPU и не очередной трансформерный ускоритель. Они берут конкретную LLM, все её веса и параметры — и запекают это прямо в кремний.

«The Model is The Computer» — слоган, который первые пять секунд звучит как очередной технохайп, но потом доходит что они имеют в виду.

Как это работает — и почему не то же самое что ASIC

GPU — универсальный молоток. Хорошо делает параллельные вычисления для чего угодно: AI, графика, HPC. ASIC типа Google TPU — уже специализация, работает только с AI-нагрузками.

Taalas пошли ещё дальше. Их HC1 — чип под одну конкретную модель. Не «под трансформеры вообще» как у Etched, а под Llama 3.1 8B конкретно. Веса модели буквально вшиты в железо.

Да, это ограничение. Но сначала о цифрах.

HC1 сделан на TSMC 6nm, 815 мм², 53 млрд транзисторов, сервер потребляет 2.5 кВт. На Llama 3.1 8B выдаёт 17 400 токенов в секунду на пользователя. Для сравнения: Cerebras (сейчас самый быстрый инференс на рынке) — около 1700 токенов/сек, GPU — 200–400 токенов/сек.

По данным Forbes, ответ на развёрнутый запрос занимает 0.138 секунды.

По стоимости: 0.75 цента за миллион токенов против 3.79 цента у Cerebras и 20–49 центов у GPU.

Потребление: 12–15 кВт на стойку против 120–600 кВт у GPU-стоек. Это важно — охлаждение дорого, и для HC1 хватает воздушного.

Откуда берётся цифра «1000x»

Честно говоря, цифра с их сайта — это сравнение в идеальных условиях. По реальным измерениям получается примерно так:

- ~10x быстрее Cerebras

- ~100x быстрее GPU

- ~50–60x дешевле GPU по стоимости токена

Всё равно впечатляет. Но «1000x» — это маркетинг, не инженерный факт. Не уверен насколько корректно их сравнение, поэтому лучше держаться реальных чисел.

Где зарыта собака

Всё это работает ровно пока Llama 3.1 8B актуальна. Когда Meta выпустит следующую версию — чип устаревает.

Taalas говорят, что могут обновить чип за два месяца — меняют только два металлических слоя, не весь кристалл с нуля. Для полупроводников это действительно быстро. Но это означает, что датацентр должен менять железо каждые 12–18 месяцев — примерно в темпе обновления популярных моделей.

Для облачного провайдера с тысячами ускорителей — это ад. Сотни SKU, каждый под свою модель и поколение. Ни один инфраструктурный инженер такое добровольно не выберет.

Показательно, что Meta только что подписала «мультигенерационное» партнёрство с Nvidia. Явно зная о Taalas. И не выбрала их.

Ещё деталь: текущий HC1 использует агрессивную квантизацию (3-bit и 6-bit параметры), что честно означает некоторую потерю качества ответов по сравнению с GPU-версией той же модели. Насколько заметно — надо тестировать.

Пока HC1 — скорее технологический демонстратор под маленькую модель. Frontier-модели типа GPT-5 или Claude Opus — вопрос следующего поколения HC2, который обещают к зиме 2026.

Итого

Мне кажется, Taalas нашли правильную идею. GPU как универсальный молоток для AI — это компромисс, и компромисс дорогой. В 100 раз дороже, если верить их цифрам по стоимости токена.

Дальше всё зависит от того, найдётся ли хотя бы один крупный облачный провайдер, готовый взять на себя операционную боль ради экономии на токенах. Если да — остальные потянутся. Если Nvidia снова победит инерцией — Taalas станет ещё одним стартапом с крутыми цифрами и без серьёзных клиентов.

Следить точно стоит. Особенно когда выйдет HC2 с поддержкой frontier-моделей.

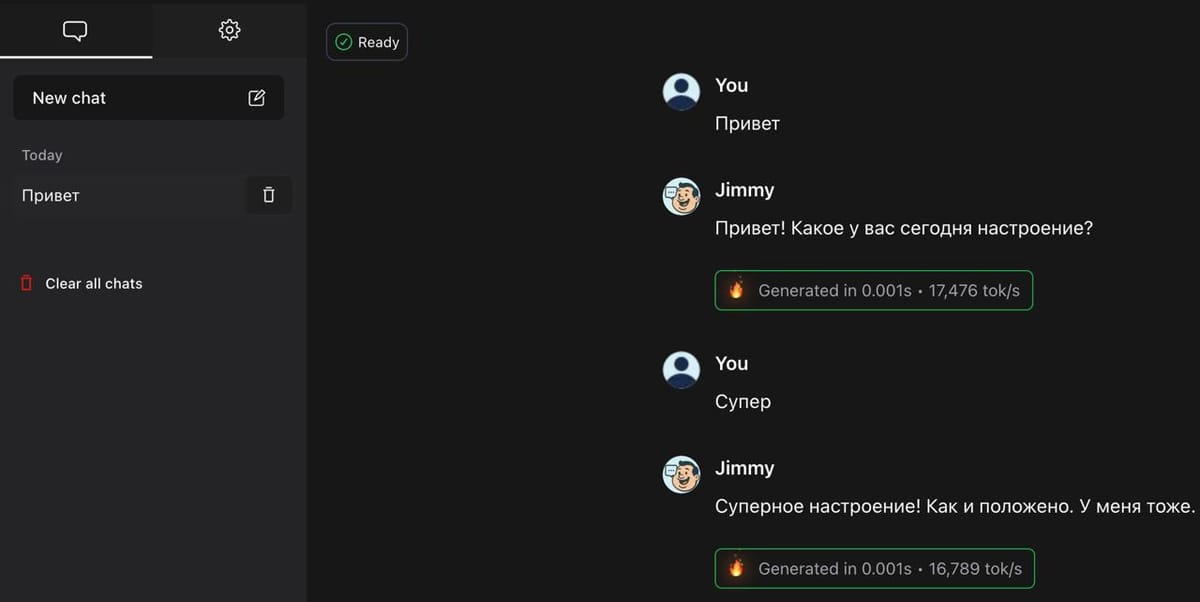

А пока — можно попробовать их демо на и почувствовать разницу лично.

Что ещё почитать

- GPT-5.3 Codex Spark — 1000 токенов/с на чипах Cerebras — для контекста, что такое быстрый инференс сегодня

- Инженеры OpenAI не пишут код — как AI меняет то, кто вообще контролирует разработку